服务热线

站点介绍

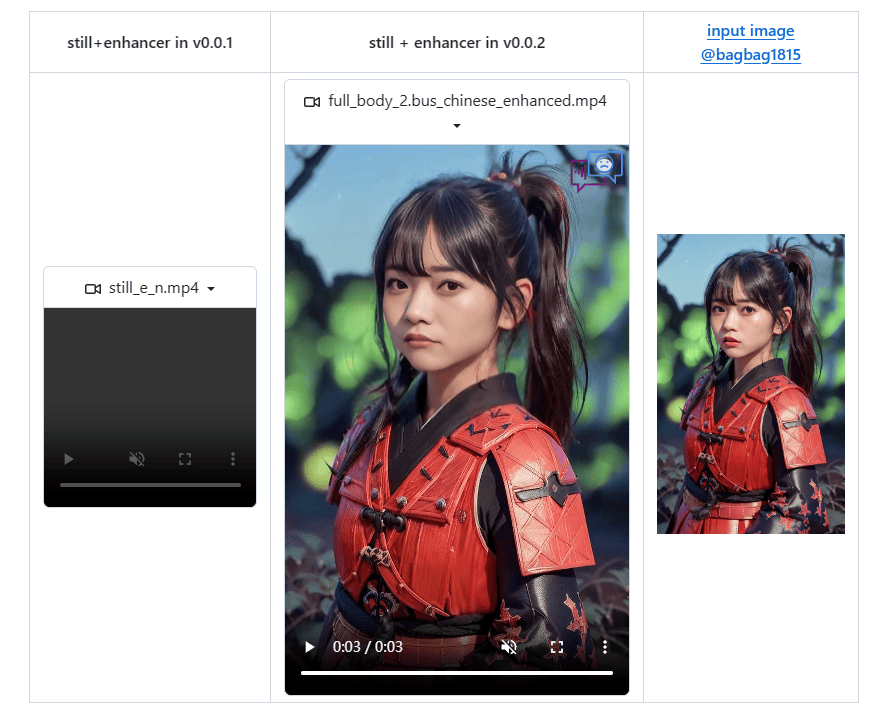

SadTalker 是由西安交通大学(西交大)开源的项目。它是一个用于生成风格化的单图说话人脸动画的工具,可以根据输入的图片和音频生成对应音频口型的视频。用户可以给模型一张图片以及一段音频文件,模型会根据音频文件把传递的图片进行人脸的相应动作,比如张嘴、眨眼、移动头部等。它可以从音频中生成3DMM的3D运动系数(头部姿势、表情),并隐式调制一种新颖的3D感知面部渲染,用于生成说话的头部运动视频。

SadTalker还提供了API接口,使得其他应用可以方便地集成其功能,如在聊天应用中实现情绪感知的自动回复。它也可以作为虚拟心理辅导员,通过识别用户的负面情绪并提供适当的慰藉性回应。在商业环境中,SadTalker可用于提升客户服务质量,针对不同情绪的客户给出更具人情味的回答。在教育领域,教师或家长可以借助SadTalker了解孩子的心理状况,帮助他们更好地处理情绪问题。同时,SadTalker还可以结合游戏或其他互动媒体,创造出能够理解和响应玩家情感的角色。

SadTalker的功能特点

SadTalker的功能特点 SadTalker的技术原理是什么?

SadTalker的技术原理是什么?SadTalker的技术原理是一个综合了深度学习、NLP、计算机视觉和机器学习等多个领域的复杂系统。它通过情感分类、文本生成、音频驱动的3D面部动画生成以及对话管理与上下文理解等技术,实现了对悲伤情绪的深入理解和高质量的情感表达。

以下是其技术原理的详细解释:

如果你经常无法打开"SadTalker",可能有以下三种原因。这里有一些解决方案:

如还有疑问,可在线留言,着急的话也可以通微信联系管理员。

1、本站所提供的 "SadTalker" 站点内容均来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由本站实际控制。

2、在2024-09-02 15:53:50收录时,该站点的内容都属于合规合法,后期该站点如出现违规,可以直接联系管理员进行删除,本站不承担任何责任。