服务热线

站点名称:Grok-1

所属分类:AI商业服务

相关标签:AI大模型 Grok-1 Grok-1人工智能 Grok-1参数量最大的开源模型 Grok-1大型语言模型 Grok-1开源AI模型 Grok-1开源项目 Grok-1模型下载

官方网址:https://github.com/xai-org/grok-1

访问官网站点介绍

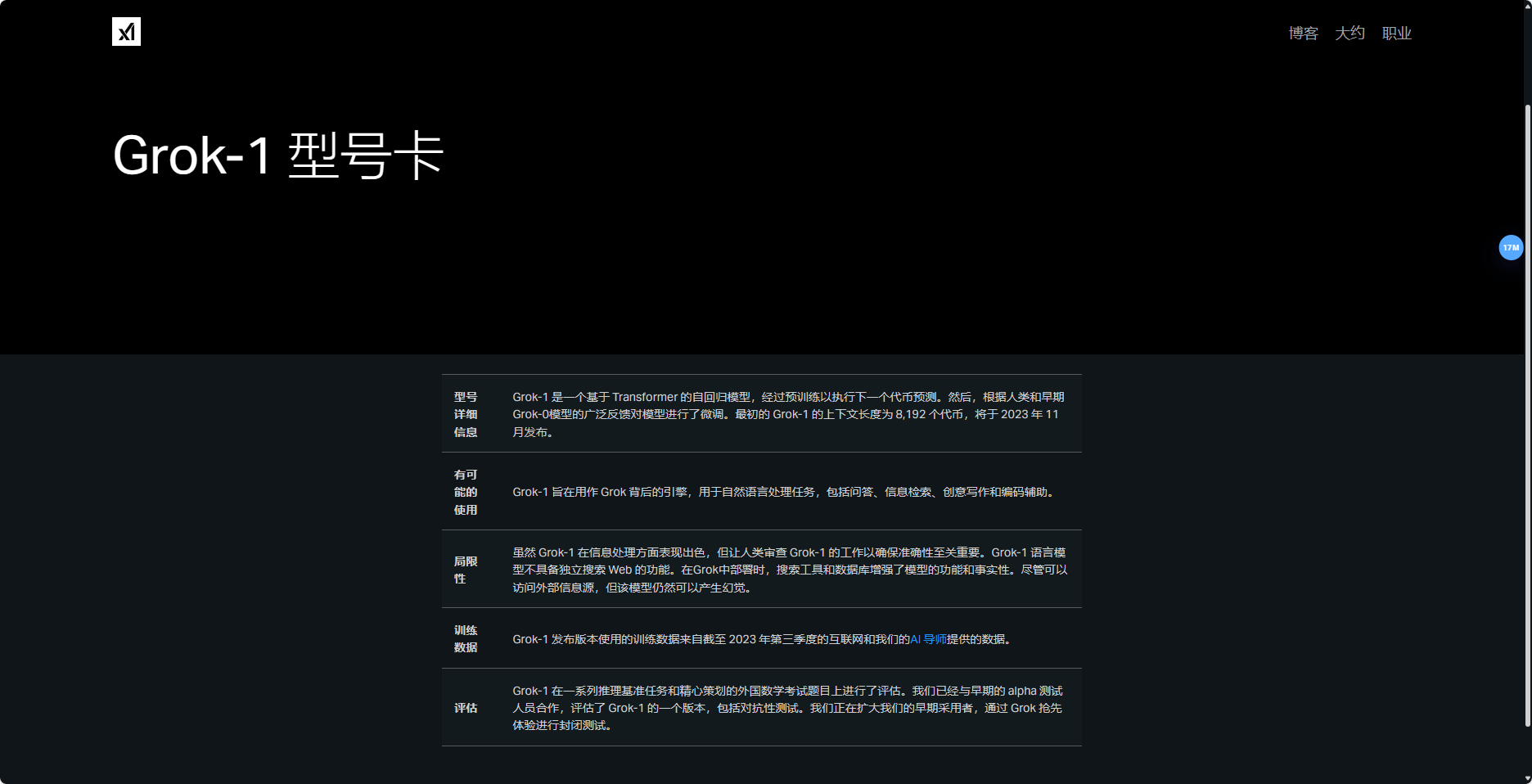

Grok-1是马斯克旗下AI创企xAI发布的一款开源AI大模型。它是一个混合专家(Mixture-of-Experts,MOE)大模型,旨在用作聊天机器人背后的引擎,用于包括问答、信息检索、创意写作和编码辅助在内的自然语言处理任务。其参数量达到了3140亿,远超OpenAI GPT-3.5的1750亿,是迄今参数量最大的开源大语言模型。

Grok-1基于大量文本数据进行训练,没有针对任何具体任务进行微调,因此它是一个通用的语言模型,可以应用于多种不同的自然语言处理任务。MOE架构的重点在于提高大模型的训练和推理效率,通过将各个领域的“专家”集合到一起,根据任务派发给不同领域的专家,最后汇总结论,从而提升效率。同时,Grok-1在信息处理方面表现出色,但需要人类审查其工作以确保准确性。

此外,xAI在遵守Apache 2.0许可证的情况下对Grok-1进行开源发布,这意味着用户可以在此许可协议下进行永久、免费的以源或者对象形式对作品进行复制、分发并进行修改。这为研究人员和开发者提供了一个新的大型语言模型资源。

项目地址官方文章介绍:https://x.ai/blog/grok-os

GitHub地址:https://github.com/xai-org/grok-1

Hugging Face地址: https://huggingface.co/xai-org/grok-1

模型权重下载地址:magnet:?xt=urn:btih:5f96d43576e3d386c9ba65b883210a393b68210e&tr=https%3A%2F%2Facademictorrents,com%2Fannounce.php&tr=udp%3A%2F%2Ftracker.coppersurfer.tk%3A6969&tr=udp%3A%2F%2Ftracker.opentrackr.org%3A1337%2Fannounce

Grok-1的功能特点

Grok-1的功能特点Grok-1的最新使用注册视频教程:

https://img.pidoutv.com/wp-content/uploads/2024/03/1473536497-1-16-1.mp4如果你经常无法打开"Grok-1",可能有以下三种原因。这里有一些解决方案:

如还有疑问,可在线留言,着急的话也可以通微信联系管理员。

1、本站所提供的 "Grok-1" 站点内容均来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由本站实际控制。

2、在2024-09-03 12:13:20收录时,该站点的内容都属于合规合法,后期该站点如出现违规,可以直接联系管理员进行删除,本站不承担任何责任。