服务热线

站点名称:DeepSpeed

所属分类:AI商业服务

相关标签:AI大模型 ai大模型有哪些 AI大模型训练方法 ai训练模型 DeepSpeed 优化库 DeepSpeed 官方网站 DeepSpeed 超大规模模型训练

官方网址:https://www.deepspeed.ai

访问官网站点介绍

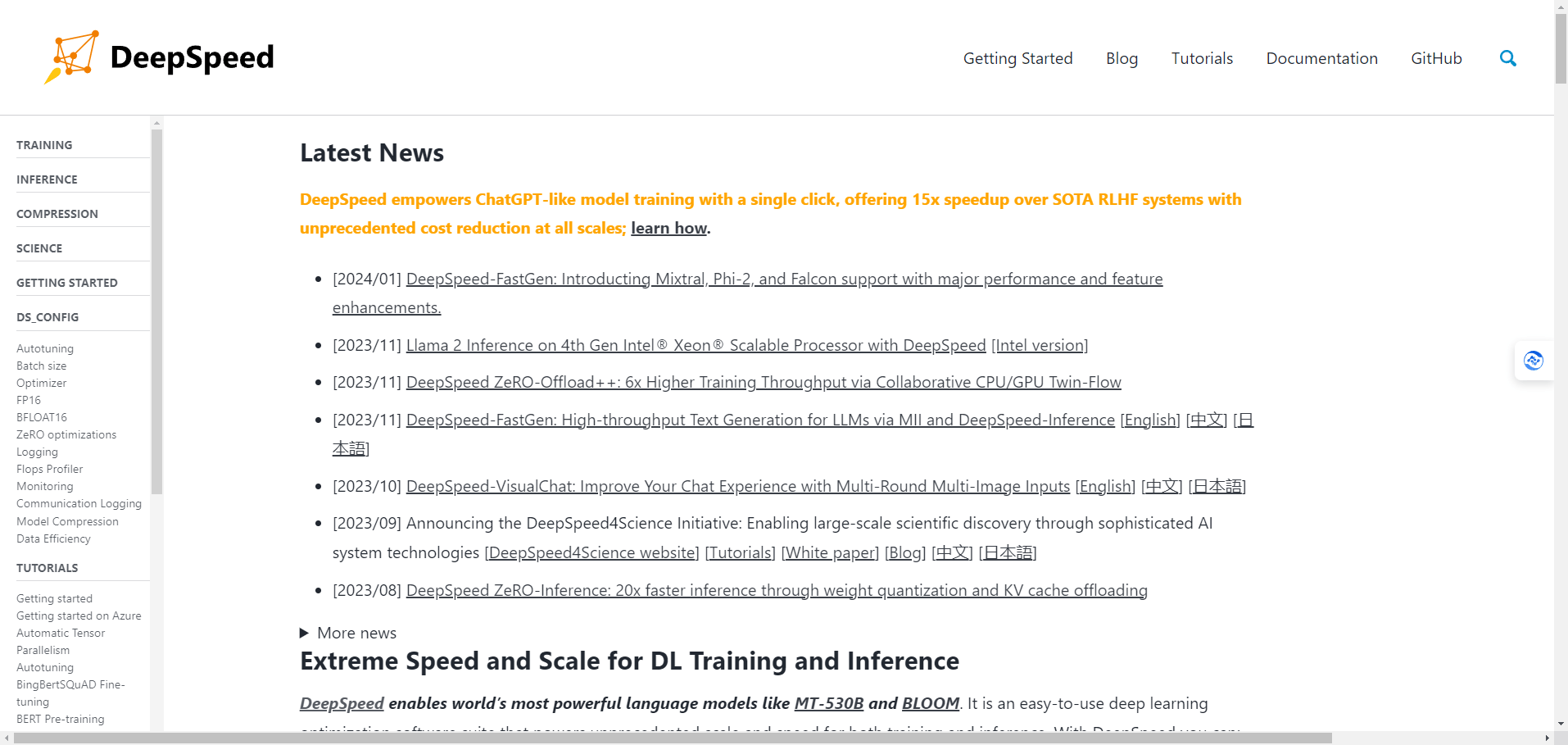

DeepSpeed是一个由微软开发的开源深度学习优化库,旨在提高大规模模型训练的效率和可扩展性。它通过多种技术手段来加速训练,包括模型并行化、梯度累积、动态精度缩放、本地模式混合精度等。DeepSpeed还提供了一些辅助工具,如分布式训练管理、内存优化和模型压缩等,以帮助开发者更好地管理和优化大规模深度学习训练任务。

DeepSpeed的功能特色及优势:1、支持超大规模模型训练,如有万亿参数的语言模型。

2、支持超长输入序列,如有10倍于传统Transformer的长度的文本、图像和语音输入。

3、支持1比特Adam优化器,可以减少5倍的通信量,提升3.5倍的分布式训练速度。

4、支持ZeRO-Offload技术,可以让单张GPU训练10倍大的模型,不耗尽显存。

5、支持与PyTorch和Huggingface Transformers等流行的深度学习框架和库的兼容和集成。

DeepSpeed支持的深度学习框架

DeepSpeed支持的深度学习框架DeepSpeed支持与PyTorch和Huggingface Transformers等流行的深度学习框架和库的兼容和集成。DeepSpeed还提供了一些模型实现,如DeepSpeed-Chat,DeepSpeed-FastGen,DeepSpeed-VisualChat等,可以用于不同的应用场景,如聊天机器人,文本生成,视觉对话等。

DeepSpeed的发展历程1、2020 年 2 月,微软首次发布了 DeepSpeed,并介绍了其核心技术之一——ZeRO(零冗余优化器),它可以显著减少模型状态量的显存占用,从而支持超大规模模型的训练。

2、2020 年 5 月,微软发布了 DeepSpeed 的第二版,增加了 ZeRO-2,一种支持有着 2000 亿参数的模型训练的技术,以及一系列计算、IO 和收敛优化功能,从而助力最快速的 BERT 训练。

3、2020 年 9 月,微软发布了 DeepSpeed 的第三版,引入了 4 项系统性新技术,包括 3D 并行化、ZeRO-Offload、稀疏注意力和 1 比特 Adam,这些技术不仅可以推动深度学习训练走向极致,同时也让这份技术的使用范围更加广泛。

4、2020 年 11 月,微软发布了 DeepSpeed 的第四版,增加了 ZeRO-Inference,一种通过权重量化和 KV 缓存卸载实现 20 倍快速推理的技术,以及 DeepSpeed-FastGen,一种通过内存/计算交换和 DeepSpeed 推理实现高吞吐量文本生成的技术。

5、2021 年 8 月,微软发布了 DeepSpeed 的第五版,增加了 ZeRO-Offload++,一种通过协作的 CPU/GPU 双流技术实现 6 倍高训练吞吐量的技术,以及 DeepSpeed-VisualChat,一种通过多轮多图像输入提升聊天体验的技术。

6、2021 年 9 月,微软发布了 DeepSpeed 的第六版,宣布了 DeepSpeed4Science 倡议,旨在通过先进的 AI 系统技术支持大规模的科学发现,以及 DeepSpeed-Chat,一种基于 DeepSpeed 的聊天机器人模型实现。

DeepSpeed进行模型训练使用教程1、安装DeepSpeed库,可以使用pip install deepspeed命令或者从GitHub仓库克隆源码并安装。

2、准备一个PyTorch模型,可以是自己编写的或者使用现有的模型,如Huggingface Transformers提供的预训练模型。

3、在模型代码中导入DeepSpeed模块,使用deepspeed.initialize()方法来初始化DeepSpeed引擎,该方法会返回一个包装了模型的引擎对象和一个数据加载器对象。

4、使用引擎对象的forward(),backward()和step()方法来执行模型的前向传播,反向传播和优化器更新。

5、使用引擎对象的save_checkpoint()和load_checkpoint()方法来保存和加载模型的检查点。

6、在命令行中使用deepspeed命令或者torch.distributed.run命令来启动模型的训练,指定所需的GPU数量,节点数量,主机地址和端口等参数,以及一个DeepSpeed配置文件的路径,该文件用于设置DeepSpeed的功能和参数,如FP16,ZeRO,优化器类型等。

如果你经常无法打开"DeepSpeed",可能有以下三种原因。这里有一些解决方案:

如还有疑问,可在线留言,着急的话也可以通微信联系管理员。

1、本站所提供的 "DeepSpeed" 站点内容均来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由本站实际控制。

2、在2024-09-03 12:15:16收录时,该站点的内容都属于合规合法,后期该站点如出现违规,可以直接联系管理员进行删除,本站不承担任何责任。